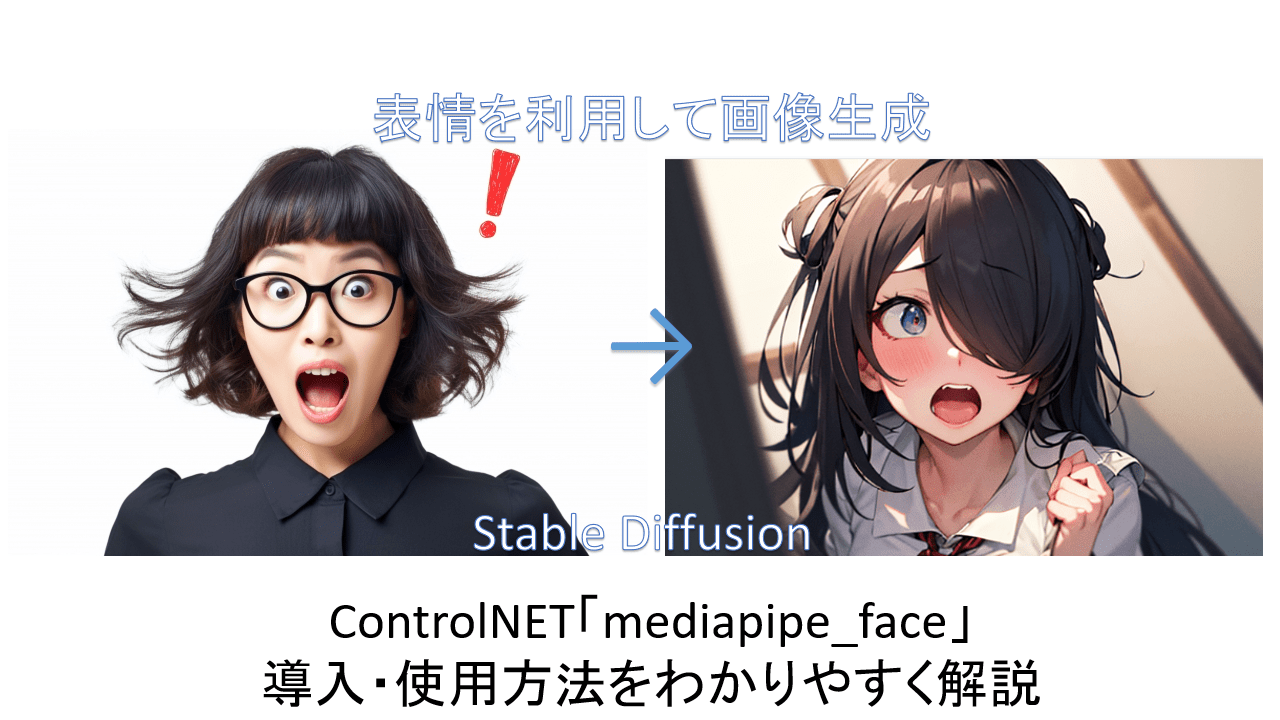

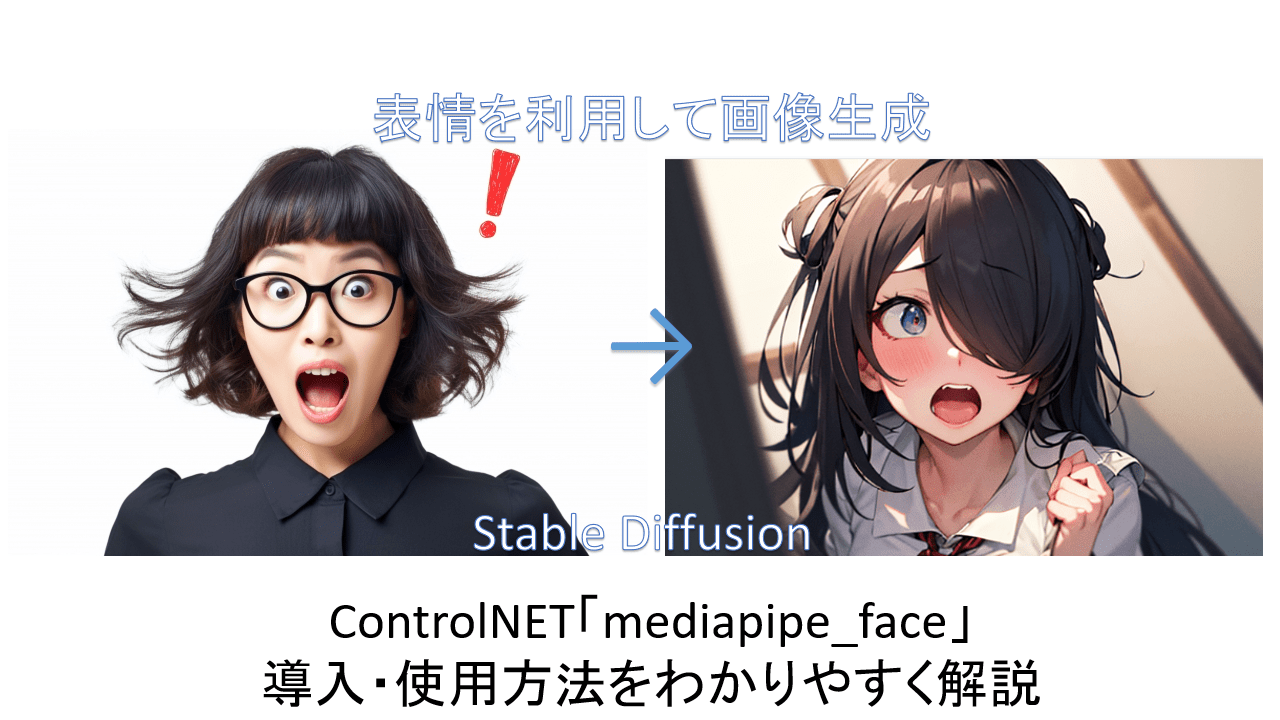

Stable diffusionの「ControlNET&拡張機能講座」第23回目。人物の表情を新たな画像に利用する「mediapipe_face」の機能をわかりやすく解説していきます。

たとえば笑っている人の表情をもとにして、それと似たような表情で違う絵柄の画像を作成したりできます。

自分の顔で表情をつくって、それを利用して画像作成ができるのニャ。

そうですね。泣き顔とか驚いた顔とか、自分を素材にするのもいいとは思います。

そんなわけでさくっと説明していきましょう。前回の「「Checkpoint Merger」をわかりやすく解説ー複数のモデルから新たなモデルを作る」は以下のリンクから。

「mediapipe_face」のインストール

「ControlNetv1.1」以上をインストールした状態であることを前提に話を進めます。まだの方や、インストールしたけどバージョンがわからんという方は以下のリンクを参照。

「mediapipe_face」用モデルのインストール

まだモデルをダウンロードしていない方は、

から、1.45Gある「control_v2p_sd15_mediapipe_face.safetensors」をダウンロードします(赤い箱マークに「LFS」と書いているボタンをクリックするとダウンロード)。

ダウンロードしたものは、「Stable Diffusion」をインストールしたフォルダ内の「stable-diffusion-webui」>「models」>「ControlNet」のフォルダに入れればOKです。

「mediapipe_face」の使い方

「Txt2img」でおこないます。

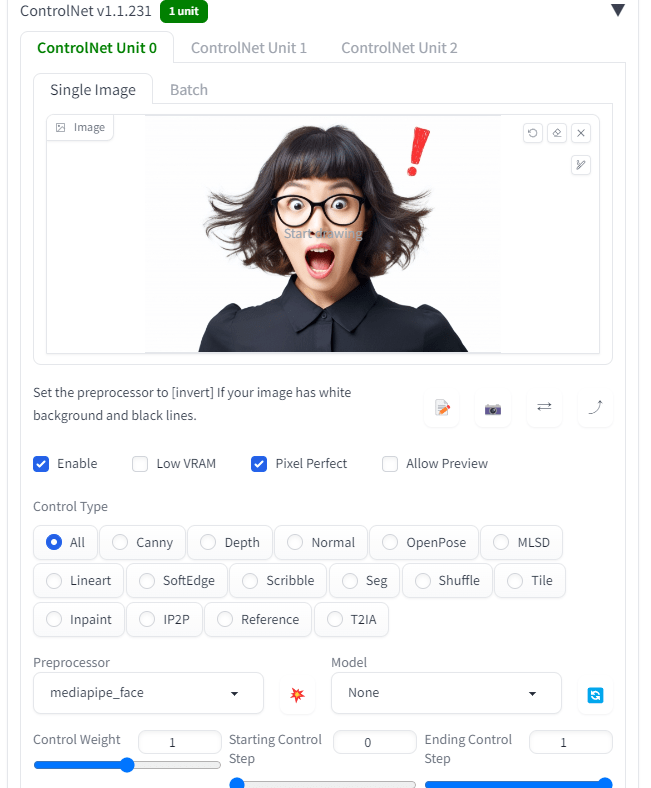

下の方にある「ControlNet」を開き、元絵を「Single Image」に放り込みます。今回は「PhotoAC」様のフリー素材を利用させてもらいました。

それから「ControlNet」を使用するため、「Enable」と「Pixel Perfect」にチェックを入れてください。

設定する「Preprocessor」は「mediapipe_face」に、「Model」は「control_v2p_sd15_mediapipe_face」とします。あとはいじらなくていいです。

プロンプトのほうは「1girl, open mouth, open eyes, surprised」(口を開く、目を開く、驚く)など適当に書いておいてください。表情を特定する記述があったほうがAI側にもわかりやすいでしょう。逆に指定しないとなかなか思い通りの表情になりません。

あとは「Generate」するだけです。

結果がタイトルの画像ですね。

それっぽくはなってるのニャ。

笑顔を利用してつくることもできます。プロンプトに「smile」とか入れておいたほうがいいですね。

まとめ

というわけで、「mediapipe_face」の使い方でした。

なかなか思い通りの表情にならないときなど、参考画像を利用したり、自分の顔を利用したりで、なんとかすることができるでしょう。

プロンプトもけっこう重要で、表情の内容をしっかり書いたほうが成功率が上がります。

いろいろ試して、うまい使い方を考えてみるのニャ。

それではまた次回の講座でお会いしましょう。【追記】次回「お手軽にイラストを実写化する方法を発見!(逆も可能)ー「tile resample」活用テクニック」できました。以下のリンクから。