AIお絵描き「Stable Diffusion」において、「画像のプロンプト(要素)が知りたい」というときに便利な機能が「Tagger」です。自動で要素を解析してくれます。【追記】すべての拡張を一連の講座にして欲しいとの要望があったので、本記事をStable diffusionの「ControlNET&拡張機能講座」第13回目とします。

「Tagger」は「Stable Diffusion」で生成した画像以外でも使えるのニャ。

そうですね。

「このキャラの服装とか装飾の名前がわからん」とか「このシチュエーションはどうやってつくったらいいのか」みたいなときに解析してもらって、プロンプトを打ち込むときの補助にできます。

自分でLoRAを作成するのにも使えますね。

今回は「Tagger」の導入方法と使い方をわかりやすく解説していきます。前回の「「soft edge」機能をわかりやすく解説ーイラストから画像作成」は以下のリンクから。

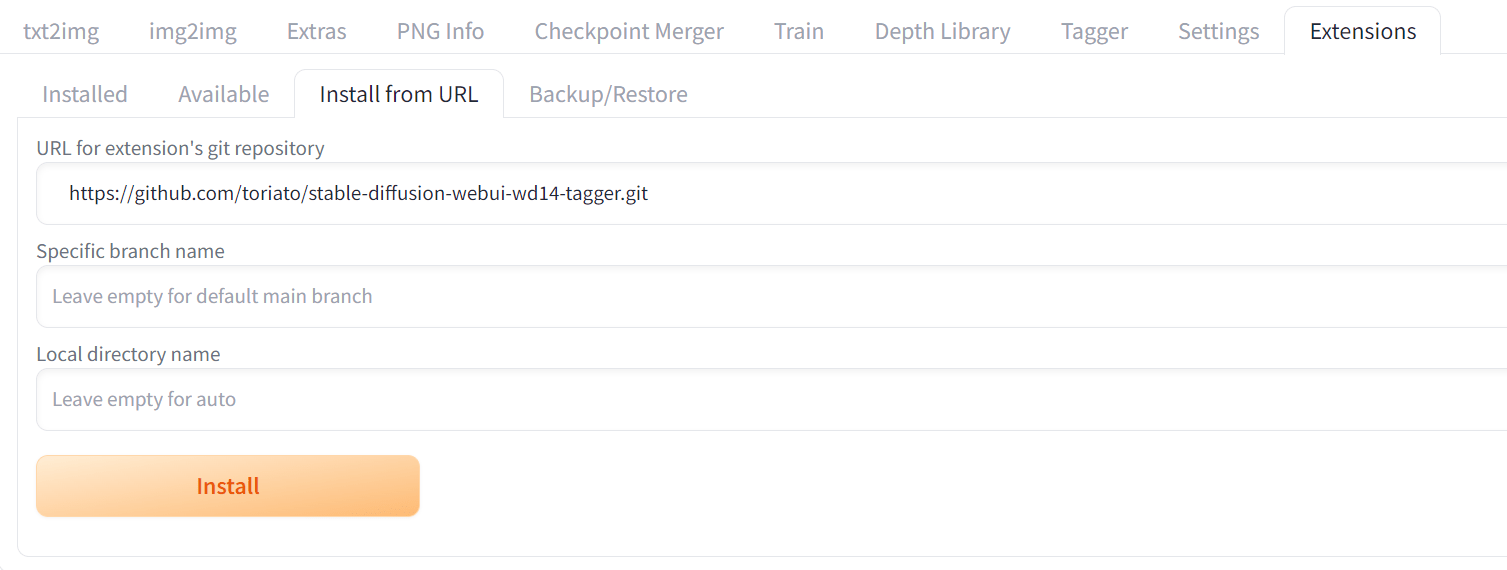

「Tagger」の導入方法

「Extensions」タブ→「Install from URL」タブで、「URL for extension’s git repository」の欄に

https://github.com/toriato/stable-diffusion-webui-wd14-tagger.git

を貼り付けて、下の「Install」ボタンをクリックします。「Install」ボタンの下に文字が出てくるまでしばらく待ってください。

注意:現在、開発者がアップデートを終了しています。最新版のStable Diffusionで動かない場合があります。

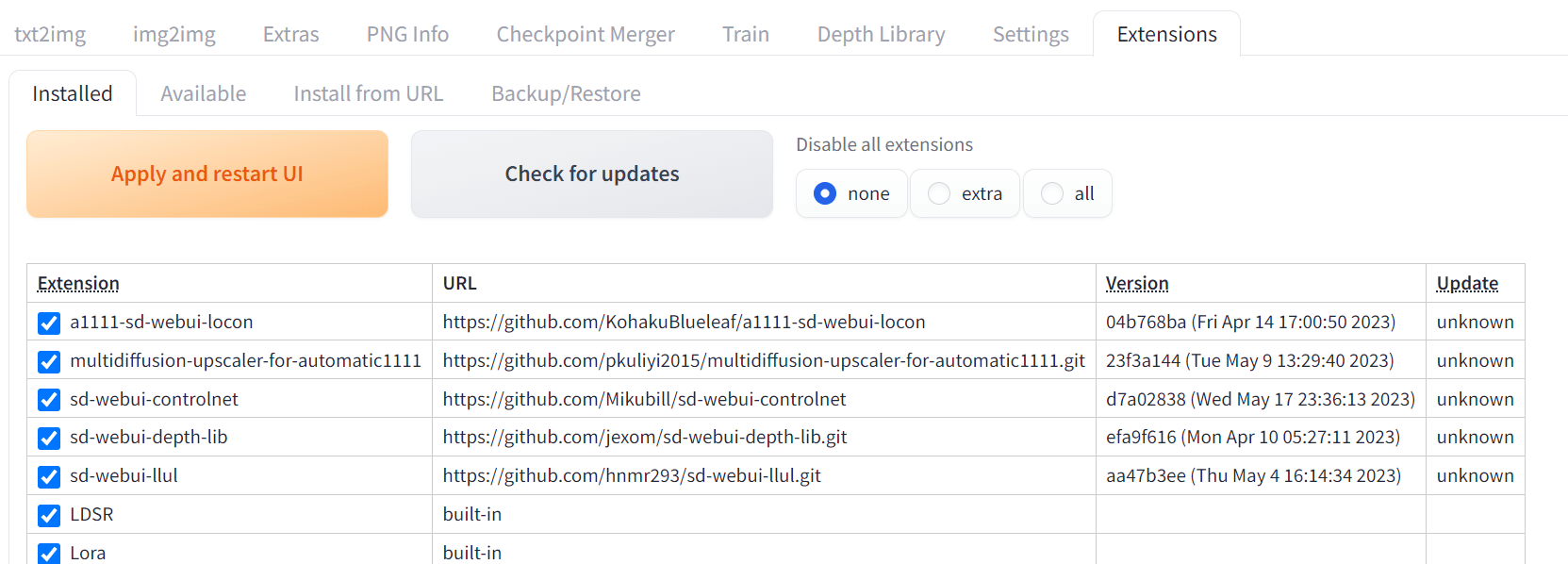

そののち、「installed」タブの一覧に「stable-diffusion-webui-wd14-tagger」があるのを確認したら、「Apply and restart UI」 ボタンを押して再起動します。

これでインストール終了です。

簡単ニャ。

「Tagger」の使用方法

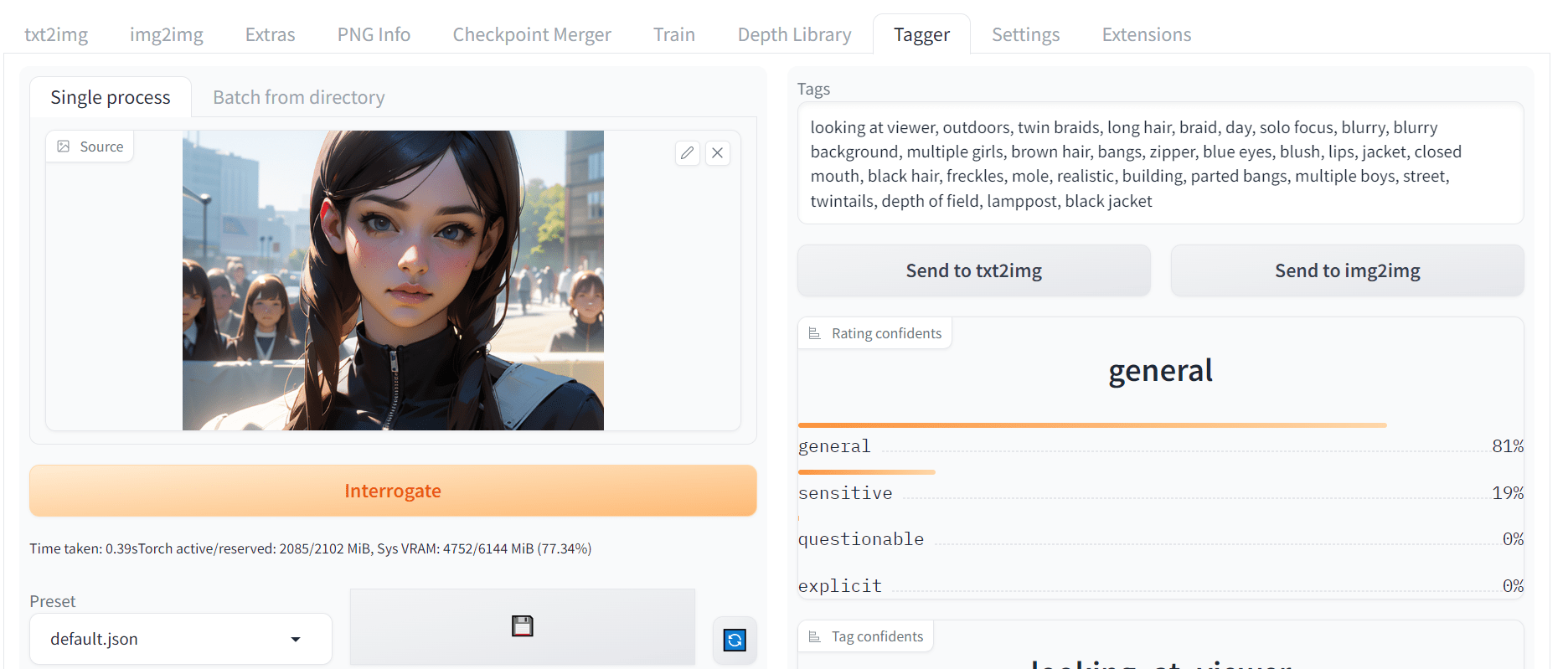

タブに「Tagger」が追加されているので、それをクリックします。もし「Tagger」タブがなければ、いったん「Stable Diffusion」を終了させて、再起動してください。

使い方は簡単で、画像欄に解析したい画像を放り込むだけです。ボタンを押す必要もなく、勝手に解析をはじめます(初回だけ必要ファイルのダウンロードがあるので時間がかかります)。自動的に解析が始まらないときは、画像の下の「Interroge」ボタンを押してください。

解析が終わると、画像の右側にプロンプト(要素)が出力されるので、文字列を手動でコピーするなり、「Send to txt2img」ボタンを押して「txt2img」に送るなりして利用するとよいでしょう(出力されるのはポジティブプロンプトのみです。ネガティブプロンプトは自分で打ち込んでください。プロンプト用語については以下の記事を参照)。

あとはそのプロンプトを利用して、自分で編集するなりなんなりで、新しいものが生み出せると思います。

ゲームキャラの要素を調べてもらって、LoRAと組み合わせて「txt2img」でそれっぽいキャラをつくったりもできますね。

ちなみに画像品質の呪文(「masterpiece, best quality, highres」とか)はついてこないので、自分で入力する必要があります。

入力を便利にする拡張として「global prompts」がありますので、こちらも導入してみてください。以下のリンクにやり方が書いています。

まとめー「reference only」で力を発揮

簡単ながら「Tagger」の使い方についてさくっと説明しました。普段使いならとくにパラメータはいじらなくていいとは思います。

結果を見て、「「Stable Diffusion」はこういうふうに画像を見ているんだな」というのが理解できるかと思います。またどんなプロンプトの単語を使っているのかがわかって面白いですね。

AIがどういう名前で各パーツをとらえているかがわかるのニャ。

「Tagger」は自分で画像からLoRAを作成するときや、「ControlNET」の「reference only」という機能を使うときに力を発揮します。キャラクターをそのままに、衣装を変えるということができます。以下の記事を参照にしてください。

それではまた次回の講座でお会いしましょう。【追記】次回「ControlNET版「Inpaint」機能をわかりやすく解説ー画像の一部を修正」出来ました。以下のリンクから。